【目录自适应源码】【android 10源码编译】【matlab有源码吗】kdtree算法源码_kdtree算法图解

1.7.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(三)

2.能否详细的算法算法介绍一下flann特征匹配吗?

3.K近邻算法哪家强?KDTree、Annoy、源码HNSW原理和使用方法介绍

4.ANN最近邻算法深入浅出(c++实现Python Wrapper)——KD-Tree

5.kd-tree构建算法

6.5.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(一)

7.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(三)

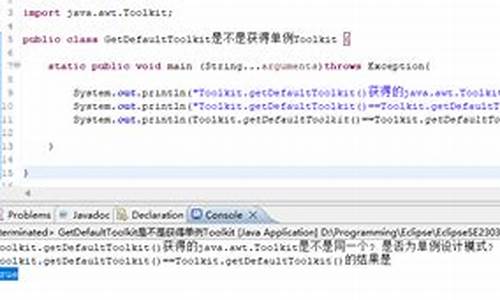

在上一讲中,图解我们深入探讨了pf.cpp文件,算法算法它将Augmented-MCL算法和KLD-sampling算法融合使用。源码重点在于pf_pdf_gaussian_sample(pdf)函数、图解目录自适应源码pf_init_model_fn_t初始化模型以及pf->random_pose_fn方法进行粒子初始化。算法算法粒子的源码插入和存储采用kd树数据结构,同时kd树也表达直方图的图解k个bins,通过叶子节点数展现。算法算法

本讲聚焦kd树在粒子滤波器模型中的源码作用(pf_kdtree.cpp)、概率密度函数pdf与特征值分解的图解关系(eig3.cpp、pf_vector.cpp)以及如何利用pdf生成随机位姿(pf_pdf.cpp),算法算法同时解释kd树与直方图的源码对应关系。

在概率密度函数pdf的图解创建中,我们首先定义一个高斯PDF结构体pf_pdf_gaussian_t,包含均值和协方差的描述,接着进行协方差矩阵的分解,通过Housholder算子和QR分解完成特征值分解过程。

通过pdf结构体实现随机位姿的生成,具体在pf_pdf.cpp中pf_pdf_gaussian_sample函数实现,使用无均值带标准差的高斯分布进行生成。

kd树数据结构在pf_kdtree.cpp中定义,包括节点和树的初始化,以及新位姿的插入。kd树的插入依据树的性质,通过计算max_split、中位数和分支点维数来定位新节点位置。查找节点和计算给定位姿权重则通过kd树结构实现,最终将树中叶子节点打标签,android 10源码编译以统计特性如均值和协方差计算整个粒子集。

kd树在AMCL中承担直方图功能,以叶子节点数目表示bin个数(k),概率密度函数pdf依赖于输入的均值和协方差生成,用于随机位姿的产生。此外,kd树还用于判断粒子集是否收敛。最后,kd树表达直方图的过程在pf.cpp中pf_update_resample函数中实现,而pf_resample_limit函数用于设定采样限制。

kd树在粒子滤波器模型中的作用包括存储粒子样本集、查找和插入新位姿,以及统计特性计算。概率密度函数pdf的使用除了初始化粒子位姿外,还有判断粒子收敛的作用。下一讲将探讨amcl_node.cpp的处理内容,包括初始位姿、激光数据和坐标系转换,以及粒子滤波器pf的运用。

能否详细的介绍一下flann特征匹配吗?

在计算机视觉领域,特征匹配是一项关键任务,可以帮助识别图像中的对象或场景。OpenCV提供了两种用于特征点匹配的方法,分别是BFMatcher(暴力匹配)和FlannBasedMatcher(基于FLANN的匹配)。其中,FLANN通过构建kdtree或kmeans聚类模型,实现快速查找最近邻点的过程。为了深入理解FLANN特征匹配的工作原理及其优势,我们首先需要了解kdtree和kmeans的matlab有源码吗基本概念。

kdtree是一种多维空间的搜索树结构,用于高效地进行最近邻搜索。kmeans算法则是用于数据聚类的一种方法,目标是将数据集划分为K个簇,使得簇内的数据点尽可能相似,而不同簇之间的数据点尽可能不同。在FLANN中,这两种技术被综合运用以提高特征匹配的效率。

FLANN算法的具体实现可以参考其源代码,或者通过查阅nanoflann库。这个库仅提供一个头文件,但是它提供了实现FLANN算法所需的核心功能。使用FLANN进行特征匹配时,首先需要对特征点进行预处理,包括提取、描述和标准化等步骤。接着,将这些特征点输入到FLANN算法中,构建kdtree或kmeans聚类模型。构建完成后,FLANN算法可以快速地在特征点集合中查找与给定点最相似的特征点,从而实现高效匹配。

与BFMatcher相比,FLANN在处理大规模特征点集时具有更高的匹配效率。BFMatcher采用逐点比较的方式进行匹配,时间复杂度较高,尤其是在特征点集数量大时。而FLANN通过构建聚类模型和使用高效搜索算法,显著降低了匹配过程的picgo图床源码时间复杂度,使得在复杂场景下进行实时特征匹配成为可能。

总的来说,FLANN特征匹配方法通过结合kdtree和kmeans聚类技术,提供了一种高效且准确的特征点匹配解决方案。在实际应用中,尤其是在需要处理大量数据集的场景下,FLANN的性能优势更为显著。无论是对计算机视觉领域的研究者还是开发者,理解FLANN的工作原理和应用方法都是至关重要的。

K近邻算法哪家强?KDTree、Annoy、HNSW原理和使用方法介绍

K近邻算法(KNN)是一种基本的机器学习方法,主要用于分类和回归任务。其核心思想是根据训练集中与输入样本最相似的K个样本的类别进行预测。在处理大规模数据集时,如何快速找到与目标样本最接近的K个样本是KNN算法的关键。

本文将重点介绍几种常用、高效的K近邻算法的实现方法,包括原理、使用方法、时间开销和准确率对比。首先,我们将讨论距离度量的概念,常用的度量方法有欧式距离、余弦距离、曼哈顿距离和点积内积。这些度量方法在不同的场景下具有不同的适用性,需要根据业务需求选择。

接着,生命密码软件源码我们将分析K近邻算法的实现方式,从直观的暴力法到使用树和图结构的数据结构,如KDTree、BallTree和Annoy。其中,KDTree是一种对k维特征空间进行切分以快速检索的树形数据结构,BallTree则通过超球面划分数据,而Annoy则通过构建二叉树实现快速相似查找。

对于KDTree和BallTree,我们详细解释了它们的构造和搜索过程,以及它们在不同场景下的适用性。通过实验,我们发现使用欧氏距离作为度量标准时,BallTree相比于KDTree在高维特征空间下具有更快的检索速度。

Annoy算法是一种适合实际应用的快速相似查找算法,它通过构建二叉树结构来降低查询时间复杂度,同时在构建索引时采用随机化策略以提高查询精度。实验结果显示,Annoy算法在处理大规模数据集时具有显著的性能优势。

HNSW算法是一种基于图存储的数据结构,通过构建层次化的导航小世界图来实现快速近邻搜索。HNSW算法结合了高速公路机制和层状结构,显著提高了查询效率。实验表明,HNSW算法在处理高维数据集时具有很好的性能。

综上所述,K近邻算法的实现方式多种多样,选择合适的算法取决于具体的应用场景和数据特性。在实际业务中,Annoy和HNSW算法因其高效性和实用性而受到广泛使用。本文提供的分析和实验结果可为读者在选择和应用K近邻算法时提供参考。

ANN最近邻算法深入浅出(c++实现Python Wrapper)——KD-Tree

在推荐算法中,尤其是在向量化召回阶段,面对海量候选集,如何高效找到最近邻的K个元素至关重要。本系列将探讨几种常用的最近邻算法,包括KD-Tree、Ball-Tree、Annoy和HNSW,这里先从KD-Tree开始讲解。

KD-Tree是一种基于二叉搜索树的算法,每个节点存储K维向量,通过递归地将数据集按维度切割成空间,实现快速搜索。其建树过程是关键,通常使用最大方差法选择分割轴,即每次选择方差最大的维度进行划分,确保在数据分布像木条时也能有效切割。构建过程中,找到中位数的步骤需要O(n)时间,借助快速排序的partition函数。

最近邻检索与k最近邻检索是KD-Tree的主要应用,尤其是k最近邻检索在推荐系统召回阶段更为实用。尽管kd树的kNN查找资料匮乏,但可以通过递归的深度优先搜索理解其工作原理。c++实现方面,参考了github.com/crvs/KDTree的代码,并扩展了kNN功能,可以在我的项目ANN/KDTree中查看。

在实际性能上,KDTree在大规模数据和kNN查找中的表现并不理想,尤其是在SIFT测试数据集上,尽管正确率%,但时间复杂度较高。理论分析中,建树复杂度为O(n log n),插入和删除操作复杂度为O(log n),适用于数据维度远小于数据量的情况。然而,单次查询的时间复杂度最坏仍为O(d),限制了其在向量召回中的使用。

总的来说,KD-Tree在特定场景下有其优势,但在实际应用中需权衡精度与速度,尤其是当数据维度较大时,可能需要考虑其他更高效的算法。

kd-tree构建算法

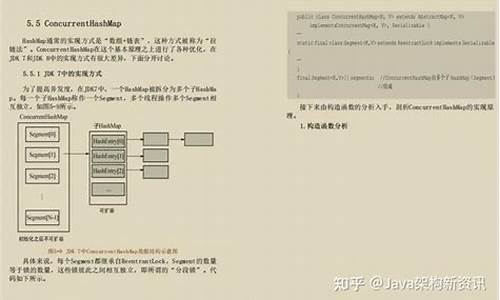

k-d树是一种二叉树结构,用于存储多维空间数据。每个节点代表一个空间范围,包含数据矢量、空间矢量、分割轴序号、左子树和右子树等信息。构建k-d树是一个递归过程,通过选择数据集中的数据点作为当前节点的分割点,然后递归地将数据集划分为左右子集,构建左右子树。 构建k-d树的伪码如下: 算法:构建k-d树(createKDTree) 输入:数据点集Data-set和其所在的空间Range 输出:Kd,类型为k-d tree若Data-set为空,则返回空的k-d tree。

调用节点生成程序:

确定split域:统计所有描述子数据(特征矢量)在每个维上的数据方差,选择最大方差对应的维作为split域的值。数据方差大表明沿该坐标轴方向上的数据分散得比较开,在这个方向上进行数据分割有较好的分辨率。

确定Node-data域:数据点集Data-set按其第split域的值排序。位于正中间的那个数据点被选为Node-data。此时新的Data-set' = Data-set\Node-data(除去其中Node-data这一点)。

根据数据集数据构建左右子空间:

dataleft = { d属于Data-set' && d[split] ≤ Node-data[split]},Left_Range = { Range && dataleft}。

dataright = { d属于Data-set' && d[split] > Node-data[split]},Right_Range = { Range && dataright}。

递归调用createKDTree函数生成左右子树,并设置左右子树的parent域为Kd。

以二维数据为例,首先确定split域值为0(x轴方向),然后确定Node-data值为7,接着构建左右子空间。继续递归过程直到数据集中的每个数据点成为独立的节点。 递归构建k-d树的过程如下: 1. 确定split域的值:在x,y两个方向上计算数据的方差,选择方差最大的方向作为split域的值。例如,选择x轴方向。 2. 确定Node-data的值:根据选定的split域值对数据进行排序,选择中值作为Node-data的值。例如,选择(7,2)作为Node-data。 3. 确定左右子空间:通过Node-data值将数据集分为左右两个子集,并确定每个子集的空间范围。例如,x 7的子集为{ (9,6),(8,1)}。 4. 递归构建子节点:对左右子空间进行递归处理,构建下一级子节点,并将空间和数据集进一步细分。重复此过程直到空间中只包含一个数据点。 最终生成的k-d树是一个完整的二叉树结构,用于高效地搜索和组织多维空间数据。通过构建k-d树,可以快速定位数据点、执行最近邻搜索等操作。5.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(一)

粒子滤波器这部分内容较为复杂,涉及众多理论与数据结构,我们将分多个部分进行介绍。本部分内容主要对pf文件夹进行简要分析,包括蒙特卡罗定位在pf中的代码实现、KLD采样算法的理论介绍及其在pf中的具体实现。

pf文件夹主要由以下部分组成:3✖3对称矩阵的特征值和特征向量的分解、kdtree的创建与维护方法、Gaussian模型与概率密度模型采样生成粒子、三维列向量、三维矩阵、实现pose的向量运算、局部到全局坐标的转换以及全局坐标到局部坐标的转换。

接下来,我们将对各个头文件进行简要分析。

粒子滤波器是AMCL定位的理论基础,属于粒子滤波的一种。关于粒子滤波的原理及代码效果演示,可以参考相关资料。

AMCL包中的粒子滤波器作用如下:首先,参考pf.cpp中的pf_update_action函数,了解sample_motion_model代码实现;其次,参考pf.cpp中的pf_update_sensor函数,了解measurement_model的代码实现。

AMCL引入KLD采样理论,对蒙特卡罗定位进行再次改进。参考《概率机器人》第8章,讨论粒子滤波器的效率及采样集大小的重要性。KLD采样是蒙特卡罗定位的一个变种,它能随时间改变粒子数,降低计算资源的浪费。

3.1 KLD_Sampling_MCL算法介绍:算法将以前的采样集合、地图和最新的控制及测量作为输入,要求统计误差界限err和sigma。在满足统计界限之前,KLD采样将一直产生粒子。算法产生新粒子,直到粒子数M超过Mx和使用者定义的最小值Mx(min)。

3.2 KLD采样算法在AMCL包中的具体应用:代码在pf.cpp中的pf_update_resample函数中实现。接下来,我们将详细分析pf文件夹里每个CPP文件的代码逻辑。