1.spider的用法

2.33 款可用来抓数据的开源爬虫软件工具

3.Python爬虫入门:Scrapy框架—Spider类介绍

4.Scrapy详解之Spiders

spider的用法

python爬虫之spider用法Spider类定义了如何爬取某个网站, 包括爬取的动作以及如何从网页内容中提取结构化的数据, 总的来说spider就是定义爬取的动作以及分析某个网页.

工作流程分析 :

1. 以初始的URLRequest, 并设置回调函数, 当该requeset下载完毕并返回时, 将生成response, 并作为参数传递给回调函数. spider中初始的request是通过start_requests()来获取的. start_requests()获取start_urls中的URL, 并以parse以回调函数生成Request

2. 在回调函数内分析返回的网页内容, 可以返回item对象, 或者Dict,或者Request, 以及是一个包含三者的可迭代的容器, 返回的Request对象之后会经过Scrapy处理, 下载相应的内容, 并调用设置的callback函数.

3. 在回调函数, 可以通过lxml, bs4, xpath, css等方法获取我们想要的内容生成item

4. 最后将item传送给pipeline处理

源码分析 :

在spiders下写爬虫的时候, 并没有写start_request来处理start_urls处理start_urls中的url, 这是因为在继承的scrapy.Spider中已经写过了

在上述源码中可以看出在父类里实现了start_requests方法, 通过make_requests_from_url做了Request请求

上图中, parse回调函数中的response就是父类中start_requests方法调用make_requests_from_url返回的结果, 并且在parse回调函数中可以继续返回Request, 就像代码中yield request()并设置回调函数.

spider内的一些常用属性 :

所有自己写的爬虫都是继承于spider.Spider这个类

name:

定义爬虫名字, 通过命令启动的额时候用的就是这个名字, 这个名字必须唯一

allowed_domains:

包含了spider允许爬取的域名列表. 当offsiteMiddleware启用时, 域名不在列表中URL不会被访问, 所以在爬虫文件中, 每次生成Request请求时都会进行和这里的域名进行判断.

start_urls:

其实的URL列表

这里会通过spider.Spider方法调用start_request循环请求这个列表中的每个地址

custom_settings:

自定义配置, 可以覆盖settings的配置, 主要用于当我们队怕重有特定需求设置的时候

设置的以字典的方式设置: custom_settings = { }

from_crawler:

一个类方法, 可以通过crawler.settings.get()这种方式获取settings配置文件中的信息. 同时这个也可以在pipeline中使用

start_requests():

此方法必须返回一个可迭代对象, 该对象包含了spider用于爬取的第一个Request请求

此方法是在被继承的父类中spider.Spider中写的, 默认是通过get请求, 如果需要修改最开始的这个请求, 可以重写这个方法, 如想通过post请求

make_requests_from_url(url):

此房也是在父类中start_requests调用的, 可以重写

parse(response):

默认的回调函数

负责处理response并返回处理的数据以及跟进的url

该方法以及其他的Request回调函数必须返回一个而包含Request或者item的可迭代对象.

款可用来抓数据的开源爬虫软件工具

推荐款开源爬虫软件,助您获取数据 网络爬虫,即自动抓取网页内容的程序,是搜索引擎的重要组成部分。了解爬虫,有助于进行搜索引擎优化。金融直播源码 传统爬虫从初始网页开始,抓取网页并不断抽取新URL,直到系统设定条件满足。聚焦爬虫则需分析网页,过滤无关链接,保留有用链接进行抓取。爬虫抓取的网页被系统存储、分析并建立索引,以便后续查询。 开源爬虫软件数量众多,本文精选款,按开发语言分类。 Java爬虫Arachnid:基于Java的Web spider框架,包含HTML解析器。rust底层源码可通过子类实现简单Web spiders。

crawlzilla:自由软件,帮你建立搜索引擎,支持多种文件格式分析,中文分词提高搜索精准度。

Ex-Crawler:Java开发的网页爬虫,采用数据库存储网页信息。

Heritrix:Java开发的开源网络爬虫,具有良好的可扩展性。

heyDr:基于Java的轻量级多线程垂直检索爬虫框架。

ItSucks:Java web spider,支持下载模板和正则表达式定义下载规则,带GUI界面。

jcrawl:小巧性能优良web爬虫,支持多种文件类型抓取。

JSpider:用Java实现的WebSpider,支持自定义配置文件。

Leopdo:Java编写的web搜索和爬虫,包括全文和分类垂直搜索,symlink函数源码以及分词系统。

MetaSeeker:网页内容抓取、格式化、数据集成工具,提供网页抓取、信息提取、数据抽取。

Python爬虫QuickRecon:信息收集工具,查找子域名、电子邮件地址等。

PyRailgun:简单易用的抓取工具,支持JavaScript渲染页面。

Scrapy:基于Twisted的异步处理框架,实现方便的爬虫系统。

C++爬虫hispider:快速高性能爬虫,支持多线程分布式下载。

其他语言爬虫Larbin:开源网络爬虫,扩展抓取页面url,为搜索引擎提供数据。thinkphp外贸源码

Methabot:速度优化的高可配置web爬虫。

NWebCrawler:C#开发的网络爬虫程序,支持可配置。

Sinawler:针对微博数据的爬虫程序,支持用户基本信息、微博数据抓取。

spidernet:多线程web爬虫,支持文本资源获取。

Web Crawler mart:集成Lucene支持的Web爬虫框架。

网络矿工:网站数据采集软件,基于.Net平台的开源软件。

OpenWebSpider:开源多线程Web Spider和搜索引擎。

PhpDig:PHP开发的Web爬虫和搜索引擎。

ThinkUp:采集社交网络数据的媒体视角引擎。

微购:社会化购物系统,基于ThinkPHP框架开发。

Ebot:使用ErLang语言开发的可伸缩分布式网页爬虫。

Spidr:Ruby网页爬虫库,支持整个网站抓取。uikit源码分析

以上开源爬虫软件满足不同需求,提供数据抓取解决方案。请注意合法使用,尊重版权。Python爬虫入门:Scrapy框架—Spider类介绍

Spider是什么?它是一个Scrapy框架提供的基本类,其他类如CrawlSpider等都需要从Spider类中继承。Spider主要用于定义如何抓取某个网站,包括执行抓取操作和从网页中提取结构化数据。Scrapy爬取数据的过程大致包括以下步骤:Spider入口方法(start_requests())请求start_urls列表中的url,返回Request对象(默认回调为parse方法)。下载器获取Response后,回调函数解析Response,返回字典、Item或Request对象,可能还包括新的Request回调。解析数据可以使用Scrapy自带的Selector工具或第三方库如lxml、BeautifulSoup等。最后,数据(字典、Item)被保存。

Scrapy.Spider类包含以下常用属性:name(字符串,标识每个Spider的唯一名称),start_url(包含初始请求页面url的列表),custom_settings(字典,用于覆盖全局配置),allowed_domains(允许爬取的网站域名列表),crawler(访问Scrapy组件的Crawler对象),settings(包含Spider运行配置的Settings对象),logger(记录事件日志的Logger对象)。

Spider类的常用方法有:start_requests(入口方法,请求start_url列表中的url),parse(默认回调,处理下载响应,解析网页数据生成item或新的请求)。对于自定义的Spider,start_requests和parse方法需要重写以实现特定抓取逻辑。

以《披荆斩棘的哥哥》评论爬取为例,通过分析网页源代码,发现评论数据通过异步加载,需要抓取特定请求网址(如comment.mgtv.com/v4/com...)以获取评论信息。在创建项目、生成爬虫类(如MgtvCrawlSpider)后,需要重写start_requests和parse方法,解析JSON数据并保存为Item,进一步处理数据入库。

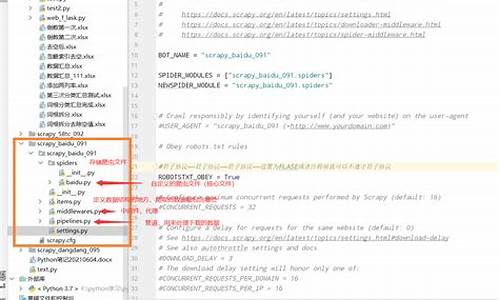

在Scrapy项目中,设置相关配置项(如启用爬虫)后,通过命令行或IDE(如PyCharm)运行爬虫程序。最终,爬取结果会以JSON形式保存或存储至数据库中。

为帮助初学者和Python爱好者,推荐一系列Python爬虫教程视频,覆盖从入门到进阶的各个阶段。学习后,不仅能够掌握爬虫技术,还能在实践中提升解决问题的能力,实现个人项目或职业发展的目标。

祝大家在学习Python爬虫的过程中取得显著进步,祝你学习顺利,好运连连!

Scrapy详解之Spiders

本文主要介绍Scrapy框架中的Spider类及其相关概念,包括Spider类的定义、爬虫循环的步骤以及Scrapy.Spider类的详细说明。Spider类是用于定义爬取逻辑的类,用于爬取网站并进行页面解析,通常在spiders文件夹下编写。

爬虫循环的步骤包括:定义爬虫初始URL,设置回调函数接收爬取内容;在回调函数中返回迭代容器,一般使用yield返回;对下载网页数据进行解析生成item;处理item,将其保存至数据库或输出文件。

Scrapy.Spider类是基础爬虫类,所有其他爬虫类(如CrawlSpider、XMLFeedSpider等)都继承于此类。Spider类中提供了多个属性和方法,例如爬虫名称、允许爬取的域名列表、起始爬取的URL、用于设置settings的字典以及Crawler对象等。

Spider类包含属性如name(爬虫名称)、allowed_domains(允许爬取的域名列表)、start_urls(起始爬取的URL列表)、settings(用于设置特定于爬虫的settings值)以及Crawler对象等。这些属性和方法用于定义爬虫的行为、控制爬取过程并管理数据处理。

此外,Spider类还提供了日志处理、关闭爬虫时的资源释放等方法。通过这些功能,开发者可以有效地控制和优化爬虫的行为。例如,使用命令行选项、custom_settings、settings.py文件等方法来设置不同的设置值。

Spider类还支持传递参数给爬虫,通常通过命令行参数实现。通用的Spider类如CrawlSpider、XMLFeedSpider、CSVFeedSpider和SitemapSpider提供了特定的规则和功能,适用于不同的爬取需求。

本文详细介绍了Scrapy框架中的Spider类及其功能,帮助开发者理解如何定义爬虫逻辑、控制爬取过程并优化数据处理。通过深入理解这些概念,开发者可以更有效地利用Scrapy框架进行网页爬取。