【mage源码分析】【怎么在网上安装游戏源码】【爱来麻将福安麻将源码】hadoop 源码编译

1.中国电信开启2020年服务器集采名单华为鲲鹏处理器首次列入招标目录

2.Hadoop3.3.5集成Hive4+Tez-0.10.2+iceberg踩坑过程

3.äºè®¡ç®ä¸ä¸è¯¾ç¨

4.å¦ä½å¨hadoop-2.6.0ä¸ç¼è¯è¿è¡èªå·±ç¼åçjava代ç

中国电信开启2020年服务器集采名单华为鲲鹏处理器首次列入招标目录

1. 在项目进行过程中,源码双方携手完成基于鲲鹏处理器的编译开源Hadoop源代码编译,让关键的源码大数据业务组件在华为TaiShan服务器上的成功部署和运行,在原有集群上实现了传统架构服务器和TaiShan服务器融合部署。编译这种兼容的源码做法,有效结合了江苏电信大数据业务。编译mage源码分析

2. 近日,源码中国电信-年服务器集中采购项目招标结果公布,编译总共个厂商中标,源码国产厂商大获全胜。编译根据评审结果,源码共有家厂商入围本次集采,编译全部是源码国内企业。其中,编译中兴通讯和紫光华三是源码怎么在网上安装游戏源码最大赢家,入围全部7个标包,其次是华为。

3. 美国对华的芯片禁令一再收紧,让民族企业华为的芯片供应出现了前所未有的困难,尤其是PC和服务器端。因此,华为打造自己的计算产业链势在必行,鲲鹏处理器便是其中的关键。

4. 年9月,华为宣布全面启航计算战略,致力于为世界提供最强算力,让信息处理不再成为瓶颈。华为海思在年1月初发布的一款兼容ARM指令集的服务器芯片鲲鹏,成为这一战略的爱来麻将福安麻将源码重要支撑。

5. 年5月,中国电信在服务器集采资格预审中,单独列出了包含华为鲲鹏芯片或海光HYGON Dhyana系列处理器的H系列全国产化服务器,这是首次将全国产化服务器单独列入招标目录。

6. 近年来自主可控成为中国科技发展重要目标,中国电信等大型企业纷纷支持国产化服务器。这种趋势推动了UOS国产操作系统从党政领域走向民用,鲲鹏生态产业链将加速完善。

7. 鲲鹏是华为于开年面向智能计算领域推出的基于ARM架构的处理器产品。华为同时还推出了基于鲲鹏的TaiShan系列服务器产品,以满足不断增长的数据中心需求。

8. 华为云鲲鹏云手机正式发布,虽然这一新技术尚存在一些缺陷,但它的量线粘合选股源码出现标志着华为在云计算领域的探索与布局。

9. 华为并没有退出鲲鹏服务器市场,而是改变了策略,把鲲鹏处理器和主板授权给更多的整机厂商,让国内更多的服务器硬件制造企业能够生产出性能优秀的服务器产品。

. 据了解,“太行s”台式机采用的CPU是华为鲲鹏s,内部集成4核或者8核。此外,该台式机支持最大G内存,拥有独立显卡。

. 华为已经在深圳试点成功,他们与南方电网深圳供电局一起合作了这个实验项目,并首次部署应用华为鲲鹏升腾处理器生态系统,涵盖操作系统、一番赏 源码 明信片处理器、服务器和存储等,并自研应用迁移平台,实现该局IDC的稳定运行。

. 升腾系列AI芯片采用了华为开创性的统一可扩展的架构,即“达芬奇架构”,实现了从极致的低功耗到极致的大算力场景的全覆盖。

. 通过大IT中台提供的硬件解耦、集群快速切换、故障自动隔离等系列特性,将营业厅系统的运行环境无缝切换到了华为TaiShan服务器,并确保系统稳定运行。

. 年9月日至日,华为在上海举办第五届HUAWEI CONNECT全联接大会。鲲鹏是华为去年推出的高性能数据中心处理器,具有高性能、高带宽、高集成度、高效能等特点,旨在满足数据中心的多样化需求。

Hadoop3.3.5集成Hive4+Tez-0..2+iceberg踩坑过程

在集成Hadoop 3.3.5、Hive 4、Tez 0..2以及Iceberg 1.3的过程中,我们面对了诸多挑战,并在多方寻找资料与测试后成功完成集成。以下为集成步骤的详细说明。

首先,确保Hadoop版本为3.3.5,这是Hive运行的前置需求。紧接着,安装Tez作为计算引擎。由于Tez 0..2的依赖版本为3.3.1,与当前的Hadoop版本不符,因此,我们需手动编译Tez以避免执行SELECT操作时出现的错误。编译前,下载官方发布的Tez源码(release-0..2),并解压以获取编译所需文件。编译过程中,注意更新pom.xml文件中的Hadoop版本号至3.3.5,同时配置protoc.path为解压后的protoc.exe路径,并添加Maven仓库源。确保只编译tez-0..2-minimal.tar.gz,避免不必要的编译耗时。完成后,将编译好的文件上传至HDFS,并在主节点hadoop配置目录下新增tez-site.xml,同步配置至所有节点后重启集群。

Hive作为基于Hadoop的数据仓库工具,提供SQL查询和数据分析能力,新版本Hive 4集成了Iceberg 1.3,无需额外配置。本次集成步骤包括下载、解压、配置环境变量及初始化元数据。下载最新的Hive 4.0.0-beta-1版本,解压并配置环境变量,删除指定jar文件以避免提示错误。修改配置文件以设置Hive环境变量,并确保连接信息正确。初始化Hive元数据后,可以使用hive执行文件启动Hive服务。编写hive_management.sh脚本以实现Hive服务的管理。

通过beeline命令进行连接,执行创建数据库和表的SQL语句,使用Hive进行数据插入和查询。值得注意的是,Hive 4.0.0-beta-1已集成Iceberg 1.3,因此无需额外加载jar包,只需将计算引擎设置为Tez。若需更新Iceberg版本,需下载Hive源码,修改依赖并编译特定包。

为了创建Iceberg分区表,使用熟悉的Hive命令语法,例如创建分区表时使用STORED BY ICEBERG。分区规范的语法也与Spark相似,可在HMS中获取Iceberg分区详细信息,并执行相应的数据转换操作。参考文档提供了从安装至配置的详细指导,确保了集成过程的顺利进行。

äºè®¡ç®ä¸ä¸è¯¾ç¨

å¦ä¹ 计ç®æºåºç¨ææ¯ï¼äºè®¡ç®ææ¯ï¼è¦å¦ä¹ ä»ä¹ä¸ä¸è¯¾è¿æè¦å¦ä¹ ä»ä¹æå课

软件å¼åï¼äºå¼åææ¯ï¼å¯ä»¥å°è¿è¾¹çç

ç°å¨å¦ä¹ äºè®¡ç®è¯¾ç¨é½éè¦å¦ä»ä¹å 容ï¼ä»¥åæ¾ä»ä¹å·¥ä½å

ä½ å¥½ï¼äºè®¡ç®æ¯æªæ¥äºèç½çåå±è¶å¿ï¼ç°å¨å ¥è¡äºè®¡ç®è¡ä¸ï¼å°±æå³çæªæ¥çé«èªåå©ï¼ä¸ºæ¤å¾å¤äººä¼éæ©åå ä¸ä¸çå¦ä¹ å¿«éå ¥è¡ãäºè®¡ç®æ¶µççç¥è¯ç¹å¾å¤ï¼åºç¨é¢åä¹æ¯è¾å¹¿æ³ï¼æ¯ä¸ä¸ªé常好çéæ©ãåªè¦ææ¡çæ£çæè½ï¼äºè®¡ç®å°±ä¸èªç¶ä¸æé®é¢ã

å¦æä½ æ³è¦ä¸ä¸çå¦ä¹ äºè®¡ç®ï¼æ´å¤éè¦çæ¯ä»åºæ¶é´åç²¾åï¼ä¸è¬å¨2Wå·¦å³ï¼4-6个ææ¶é´ä¸çãåéç课ç¨å¾ä¸éï¼ä½ å¯ä»¥æ ¹æ®èªå·±çå®é éæ±å»å®å°çä¸ä¸ï¼å 好好è¯å¬ä¹åï¼åéæ©éåèªå·±çãåªè¦åªåå¦å°çä¸è¥¿ï¼åéèªç¶ä¸ä¼å·®ã

大æ°æ®ä¸ä¸ä¸»è¦å¦ä»ä¹è¯¾ç¨

大æ°æ®ææ¯ä¸ä¸å±äºäº¤åå¦ç§ï¼ä»¥ç»è®¡å¦ãæ°å¦ã计ç®æºä¸ºä¸å¤§æ¯ææ§å¦ç§ï¼çç©ãå»å¦ãç¯å¢ç§å¦ãç»æµå¦ã社ä¼å¦ã管çå¦ä¸ºåºç¨æå±æ§å¦ç§ã

æ¤å¤è¿éå¦ä¹ æ°æ®ééãåæãå¤ç软件ï¼å¦ä¹ æ°å¦å»ºæ¨¡è½¯ä»¶å计ç®æºç¼ç¨è¯è¨çï¼ç¥è¯ç»ææ¯äºä¸å¤è½å¤åçè·¨ç人æ(æä¸ä¸ç¥è¯ãææ°æ®æç»´)ã

以ä¸å½äººæ°å¤§å¦ä¸ºä¾ï¼

åºç¡è¯¾ç¨ï¼æ°å¦åæãé«ç代æ°ãæ®éç©çæ°å¦ä¸ä¿¡æ¯ç§å¦æ¦è®ºãæ°æ®ç»æãæ°æ®ç§å¦å¯¼è®ºãç¨åºè®¾è®¡å¯¼è®ºãç¨åºè®¾è®¡å®è·µã

å¿ ä¿®è¯¾ï¼ç¦»æ£æ°å¦ãæ¦çä¸ç»è®¡ãç®æ³åæä¸è®¾è®¡ãæ°æ®è®¡ç®æºè½ãæ°æ®åºç³»ç»æ¦è®ºã计ç®æºç³»ç»åºç¡ã并è¡ä½ç³»ç»æä¸ç¼ç¨ãéç»æå大æ°æ®åæã

é修课ï¼æ°æ®ç§å¦ç®æ³å¯¼è®ºãæ°æ®ç§å¦ä¸é¢ãæ°æ®ç§å¦å®è·µãäºèç½å®ç¨å¼åææ¯ãæ½æ ·ææ¯ãç»è®¡å¦ä¹ ãåå½åæãéæºè¿ç¨ã

(3)äºè®¡ç®ä¸ä¸è¯¾ç¨æ©å±é 读ï¼

大æ°æ®å²ä½ï¼

1ã大æ°æ®ç³»ç»æ¶æå¸

大æ°æ®å¹³å°æ建ãç³»ç»è®¾è®¡ãåºç¡è®¾æ½ã

æè½ï¼è®¡ç®æºä½ç³»ç»æãç½ç»æ¶æãç¼ç¨èå¼ãæ件系ç»ãåå¸å¹¶è¡å¤ççã

2ã大æ°æ®ç³»ç»åæå¸

é¢åå®é è¡ä¸é¢åï¼å©ç¨å¤§æ°æ®ææ¯è¿è¡æ°æ®å®å ¨çå½å¨æ管çãåæååºç¨ã

æè½ï¼äººå·¥æºè½ãæºå¨å¦ä¹ ãæ°çç»è®¡ãç©éµè®¡ç®ãä¼åæ¹æ³ã

3ãhadoopå¼åå·¥ç¨å¸ã

解å³å¤§æ°æ®åå¨é®é¢ã

4ãæ°æ®åæå¸

ä¸åè¡ä¸ä¸ï¼ä¸é¨ä»äºè¡ä¸æ°æ®æéãæ´çãåæï¼å¹¶ä¾æ®æ°æ®ååºè¡ä¸ç 究ãè¯ä¼°åé¢æµçä¸ä¸äººåãå¨å·¥ä½ä¸éè¿è¿ç¨å·¥å ·ï¼æåãåæãåç°æ°æ®ï¼å®ç°æ°æ®çåä¸æä¹ã

5ãæ°æ®ææå·¥ç¨å¸

åæ°æ®ææè¦ä»æµ·éæ°æ®ä¸åç°è§å¾ï¼è¿å°±éè¦ä¸å®çæ°å¦ç¥è¯ï¼æåºæ¬çæ¯å¦çº¿æ§ä»£æ°ãé«ç代æ°ãå¸ä¼åãæ¦ç论çãç»å¸¸ä¼ç¨å°çè¯è¨å æ¬PythonãJavaãCæè C++ï¼æèªå·±ç¨Pythonæè Javaæ¯è¾å¤ãææ¶ç¨MapReceåç¨åºï¼åç¨Hadoopæè Hypæ¥å¤çæ°æ®ï¼å¦æç¨Pythonçè¯ä¼åSparkç¸ç»åã

Linuxäºè®¡ç®è¯¾ç¨å ·ä½å¦ä»ä¹

ä¼å°±ä¸linuxäºè®¡ç®å¹è®å¦é¢çåäºå¹å »å¤æ¹ä½åå±çäºè®¡ç®äººæï¼è¯¾ç¨è®¾ç½®ç§å¦åçï¼é¢å0åºç¡äººåï¼æå¦å 容涵çåå广æ³ï¼å¤§å项ç®å®è®ï¼å®ææ§æ´å¼ºã

ä¼å°±ä¸Linuxäºè®¡ç®çå¹è®è¯¾ç¨å 容ä¸è¬å为å 个é¶æ®µï¼ç¬¬ä¸é¶æ®µä¸»è¦å¦ä¹ ç½ç»åºç¡ï¼å æ¬è®¡ç®æºç½ç»(以太ç½ãTCP/IPç½ç»æ¨¡å)ãäºè®¡ç®ç½ç»(ç½ç»QoSã交æ¢æºä¸è·¯ç±å¨)ï¼é å¤æä¼ä¸çº§é¡¹ç®å®æï¼IPå°åé ç½®ä¸DNS解æã

第äºé¶æ®µå°å¦ä¹ Linuxåºç¡ï¼å æ¬Linuxæä½ç³»ç»(æ件æéãä½ä¸æ§å¶ä¸è¿ç¨ç®¡ç)以åLinuxé«çº§ç®¡ç(SedãAwkå·¥å ·ãæºç ç¼è¯)ãä¼ä¸çº§é¡¹ç®å®æ为ï¼äºæ°æ®ä¸å¿ä¸»æºCPUèµæºå©ç¨çå®æ¶ç»è®¡ãåæç³»ç»ã

第ä¸é¶æ®µå¦ä¹ Linuxè¿ç»´èªå¨åï¼ä¼ä¸çº§é¡¹ç®å®æ为Python+Shellå®ç°ä¼ä¸çº§FTPæ件ç»ä¸ç®¡çã

第åé¶æ®µæ¯æ°æ®åºè¿ç»´ç®¡ççå¦ä¹ ï¼ä¼ä¸çº§é¡¹ç®å®æï¼MySQL Galeraé«å¯ç¨é群ç¯å¢é¨ç½²ãå¼æ¥æ¶æ¯éåé群RabbitMQé¨ç½²ä¸è¿ç»´ã

第äºé¶æ®µçå¹è®å 容为ä¼ä¸çº§äºæ¶æ管çä¸ç»¼åå®æ(PaaS+TaaS)ï¼é¡¹ç®è®ç»çæ¯åºäºLAMPæ¶æå®ç°äºè®¡ç®PaaSå¹³å°å ¸ååºç¨é¨ç½²ä¸è¿ç»´ï¼éè¿Nginxå®ç°åä¸çº§å¹¶å访é®å¤çã

æåä¸ä¸ªé¶æ®µå°±æ¯å°±ä¸æ导ï¼ä»ç®åãé¢è¯æå·§çå±é¢å©å¦åæåï¼å¹å »å¦åæ²é表达è½åï¼è®©å¦åæ¸ æ°äºè§£èä¸åå±è§åï¼æç¡®èªèº«å®ä½ï¼æ¾å°éåèªèº«åå±çå·¥ä½ã

计ç®æºäºè®¡ç®æåªäºä¸»å¹²è¯¾ç¨

çµèç计ç®ä¸»è¦é è¿ç®å¨ã

è¿ç®å¨ï¼arithmetic unitï¼è®¡ç®æºä¸æ§è¡åç§ç®æ¯åé»è¾è¿ç®æä½çé¨ä»¶ãè¿ç®å¨çåºæ¬æä½å æ¬å ãåãä¹ãé¤ååè¿ç®ï¼ä¸ãæãéãå¼æçé»è¾æä½ï¼ä»¥å移ä½ãæ¯è¾åä¼ éçæä½ï¼äº¦ç§°ç®æ¯é»è¾é¨ä»¶ï¼ALUï¼ã

è¿ç®å¨ç±ç®æ¯é»è¾åå ï¼ALUï¼ãç´¯å å¨ãç¶æå¯åå¨ãéç¨å¯åå¨ç»çç»æãç®æ¯é»è¾è¿ç®åå ï¼ALUï¼çåºæ¬åè½ä¸ºå ãåãä¹ãé¤ååè¿ç®ï¼ä¸ãæãéãå¼æçé»è¾æä½ï¼ä»¥å移ä½ãæ±è¡¥çæä½ã计ç®æºè¿è¡æ¶ï¼è¿ç®å¨çæä½åæä½ç§ç±»ç±æ§å¶å¨å³å®ãè¿ç®å¨å¤ççæ°æ®æ¥èªåå¨å¨ï¼å¤çåçç»ææ°æ®é常éååå¨å¨ï¼æææ¶å¯åå¨è¿ç®å¨ä¸ãä¸Control Unitå ±åç»æäºCPUçæ ¸å¿é¨åã

è¿ç®å¨çå¤ç对象æ¯æ°æ®ï¼æ以æ°æ®é¿åº¦å计ç®æºæ°æ®è¡¨ç¤ºæ¹æ³ï¼å¯¹è¿ç®å¨çæ§è½å½±åæ大ã年代微å¤çå¨å¸¸ä»¥1个ã4个ã8个ã个äºè¿å¶ä½ä½ä¸ºå¤çæ°æ®çåºæ¬åä½ã大å¤æ°éç¨è®¡ç®æºå以ããä½ä½ä¸ºè¿ç®å¨å¤çæ°æ®çé¿åº¦ãè½å¯¹ä¸ä¸ªæ°æ®

è¿ç®å¨

çææä½åæ¶è¿è¡å¤ççè¿ç®å¨ç§°ä¸ºå¹¶è¡è¿ç®å¨ãå¦æä¸æ¬¡åªå¤çä¸ä½ï¼å称为串è¡è¿ç®å¨ãæçè¿ç®å¨ä¸æ¬¡å¯å¤çå ä½ ï¼é常为6æ8ä½ï¼ï¼ä¸ä¸ªå®æ´çæ°æ®åæè¥å¹²æ®µè¿è¡è®¡ç®ï¼ç§°ä¸ºä¸²/并è¡è¿ç®å¨ãè¿ç®å¨å¾å¾åªå¤çä¸ç§é¿åº¦çæ°æ®ãæçä¹è½å¤çå ç§ä¸åé¿åº¦çæ°æ®ï¼å¦ååé¿è¿ç®ãåååé¿è¿ç®ãåååé¿è¿ç®çãæçæ°æ®é¿åº¦å¯ä»¥å¨è¿ç®è¿ç¨ä¸æå®ï¼ç§°ä¸ºååé¿è¿ç®ã

æç §æ°æ®çä¸å表示æ¹æ³ï¼å¯ä»¥æäºè¿å¶è¿ç®å¨ãåè¿å¶è¿ç®å¨ãåå è¿å¶è¿ç®å¨ãå®ç¹æ´æ°è¿ç®å¨ãå®ç¹å°æ°è¿ç®å¨ãæµ®ç¹æ°è¿ç®å¨çãæç §æ°æ®çæ§è´¨ï¼æå°åè¿ç®å¨åå符è¿ç®å¨çã

å®ç主è¦åè½æ¯è¿è¡ç®æ¯è¿ç®åé»è¾è¿ç®ã

è¿ç®å¨è½æ§è¡å¤å°ç§æä½åæä½é度ï¼æ å¿çè¿ç®å¨è½åç强弱ï¼çè³æ å¿ç计ç®æºæ¬èº«çè½åãè¿ç®å¨æåºæ¬çæä½æ¯å æ³ãä¸ä¸ªæ°ä¸é¶ç¸å ï¼çäºç®åå°ä¼ éè¿ä¸ªæ°ãå°ä¸ä¸ªæ°ç代ç æ±è¡¥ï¼ä¸å¦ä¸ä¸ªæ°ç¸å ï¼ç¸å½äºä»åä¸ä¸ªæ°ä¸åå»åä¸ä¸ªæ°ãå°ä¸¤ä¸ªæ°ç¸åå¯ä»¥æ¯è¾å®ä»¬ç大å°ã

å·¦å³ç§»ä½æ¯è¿ç®å¨çåºæ¬æä½ãå¨æ符å·çæ°ä¸ï¼ç¬¦å·ä¸å¨èåªç§»æ°

è¿ç®å¨

æ®ä½ï¼ç§°ä¸ºç®æ¯ç§»ä½ãè¥æ°æ®è¿å符å·çææä½ä¸é½ç§»å¨ï¼ç§°ä¸ºé»è¾ç§»ä½ãè¥å°æ°æ®çæé«ä½ä¸æä½ä½é¾æ¥è¿è¡é»è¾ç§»ä½ï¼ç§°ä¸ºå¾ªç¯ç§»ä½ã

è¿ç®å¨çé»è¾æä½å¯å°ä¸¤ä¸ªæ°æ®æä½è¿è¡ä¸ãæãå¼æï¼ä»¥åå°ä¸ä¸ªæ°æ®çåä½æ±éãæçè¿ç®å¨è¿è½è¿è¡äºå¼ä»£ç çç§é»è¾æä½ã

ä¹ãé¤æ³æä½è¾ä¸ºå¤æãå¾å¤è®¡ç®æºçè¿ç®å¨è½ç´æ¥å®æè¿äºæä½ãä¹æ³æä½æ¯ä»¥å æ³æä½ä¸ºåºç¡çï¼ç±ä¹æ°çä¸ä½æå ä½è¯ç æ§å¶é次产çé¨å积ï¼é¨å积ç¸å å¾ä¹ç§¯ãé¤æ³åå常以ä¹æ³ä¸ºåºç¡ï¼å³éå®è¥å¹²å åä¹ä»¥é¤æ°ï¼ä½¿å®è¿ä¼¼ä¸º1ï¼è¿äºå åä¹è¢«é¤æ°åå¾åã没ææ§è¡ä¹æ³ãé¤æ³ç¡¬ä»¶ç计ç®æºå¯ç¨ç¨åºå®ç°ä¹ãé¤ï¼ä½éåº¦æ ¢å¾å¤ãæçè¿ç®å¨è¿è½æ§è¡å¨ä¸æ¹æ°ä¸å¯»æ±æ大æ°ï¼å¯¹ä¸æ¹æ°æ®è¿ç»æ§è¡åä¸ç§æä½ï¼æ±å¹³æ¹æ ¹çå¤ææä½ã

å¸ææè½å¸®å©ä½ 解çéæã

äºè®¡ç®éè¦å¦ä»ä¹è¯¾ç¨ææ¨èå

æ¨èä¸åéçäºè®¡ç®è¯¾ç¨ï¼å¦åéäºè®¡ç®æç¨åºæ¥çå¦åé½è¯´æ¾å·¥ä½å¾å®¹æã

äºè®¡ç®éä¿è§£éï¼äºè®¡ç®éè¦å¦ä»ä¹è¯¾ç¨

äºè®¡ç®éä¿ç讲ï¼äºç«¯æ¶è®¾ä¸å°æ§è½å¼ºå²çæå¡å¨ï¼æ¯å¦ï¼æ ¸çCPU ãG çå åï¼N个T çåå¨çãå¨è¿æ ·æçé ç½®å¾å¯ä½çæå¡å¨ä¸éè¿èææºææ¯ï¼å建å å个èææºï¼ä»å®¿ä¸»æå¡å¨ç¡¬ä»¶é ç½®ä¸åååºèµæºé é¢ï¼ï¼å®¢æ·æºéè¿âè¿ç¨æ¡é¢åè®®âæâè¿ç¨æ§å¶åè®®âè¿æ¥å°èææºï¼è¿æ ·ä½ å°±å¯ä»¥å¨æ¬å°å®¢æ·æºä½¿ç¨è¿å°è¿ç¨çèææºã æ以çè¿ç®(计ç®)é½æ¯å¨è¿å°èææºä¸å®æçï¼æ¬å°å®¢æ·æºåªæ¯è¾å ¥ä¸è¾åºï¼éæ¬å°è®¡ç®ï¼ãå¦ä¹ äºè®¡ç®å¯ä»¥å»ççopenstack ,å¤äºè§£KVM çã

äºè®¡ç®ä¸Hadoopç课ç¨å 容æ¯ä»ä¹

课ç¨ç®æ

çæåææ¡äºè®¡ç®çæ¶æä¸åç

äºè§£å¤§è§æ¨¡æ°æ®å¤ççæ ¸å¿ææ¯

çæ并ç解ä¼ä¸å¤§è§æ¨¡æ°æ®å¤çåºç¨ç注æäºé¡¹

对å¼æºç³»ç»Hadoopçè¡ä¸åºç¨

课ç¨å 容

Hadoop

ææ¯åå ¶åºç¨åºç¡

1天

Hadoop

管çå

2天

Hadoop

å¼åå

2天

Hive

å¼å管ç

1天

æ¥æºï¼åä¸æºè½åæ°æ®ä»åºç±å¥½è

æä¾ï¼åä¸æºè½åäºè®¡ç®ãããããéªè®ï¼ï¼ï¼ï¼ï¼å æ¬è¿ä¸ªè¯¾

äºè®¡ç®çåºç¡è¯¾ç¨

äºè®¡ç®æ¯ä¸å¥ç³»ç»ç解å³æ¹æ¡ãéè¦ä»å®è§çºµåå»çï¼åå°å¾®è§å ·ä½çæ个äºè®¡ç®çå项æä¸æ¯ãå®å±å为åºç¡æ¶æå±ï¼IaaSï¼ï¼å¹³å°æ¶æå±ï¼PaaSï¼ï¼è½¯ä»¶æ¶æå±ï¼SaaSï¼ï¼æå¡æ¶æå±ï¼BPaaSï¼ãæ¯ä¸ªå±é¢ç建设å®æ½è¿ç¨åå¯ä»¥ç¬ç«åå¨ï¼å¹¶æ²¡æå ååªåï¼å建åªåçå å顺åºãå ¶ä¸IaaSæ¯å¿ ç»ä¹è·¯ã纵åææ¡ä½äºï¼å横åç»åå»çãæ¯å¦ï¼IaaSå为åå¨æ± ï¼è´è½½åè¡¡æ± ï¼èç¹è®¡ç®æ± ï¼å ¶ä¸ååç»å为å°åæºè®¡ç®æ± ï¼æå¡å¨è®¡ç®æ± çãåææä½ç³»ç»çæ¬çä¸ååç»åï¼çã

äºè®¡ç®å¹è®éè¦å å¦ä»ä¹

é¶åºç¡å¦ä¹ linuxè½å¦ä¼å?

å æ¥è¯´ç»è®ºï¼é¶åºç¡å¦ä¹ Linuxæ¯å¯ä»¥å¦ä¼çï¼èä¸ç°å¨å¹è®æºæç课ç¨é½æ¯é¶åºç¡éå¦çï¼åæé½æåºç¡ç¥è¯çå¦ä¹ ï¼é计ç®æºä¸ä¸ãé¶åºç¡å°ç½é½æ¯å¯ä»¥ä»å¤´å¼å§å¦ä¹ çã

èä¸å¨æ¯ä¸ªé¶æ®µé½æé¶æ®µæ£æµï¼æ¥æ¼è¡¥ç¼ºï¼èæ ¸å¦åçå¦ä¹ ç»æï¼ä¸åæ ¼ä¸è¿å ³çè¿è¦åå¦ä¹ ï¼ç´å°åæ ¼è¿å ³ã

éè¦å åå¤åªäºåºç¡ç¥è¯å?

Linuxéè¦åå¤çåºç¡ç¥è¯é¦å æ¯ç½ç»åºç¡ï¼å æ¬è®¡ç®æºç½ç»(以太ç½ãTCP/IPç½ç»æ¨¡å)ãäºè®¡ç®ç½ç»(ç½ç»QoSã交æ¢æºä¸è·¯ç±å¨)ï¼è¦å¦ä¹ å°ç½ç»åºæ¬æ¦å¿µåçãç½ç»çååæ¹å¼ï¼äºè§£æ°æ®ä¸å¿ç¡¬ä»¶è®¾æ½ï¼æ°æ®éä¿¡åºæ¬åçï¼ä»¥å¤ªç½åºç¡åç°æéä¿¡ç½ç»ä¼ è¾è§èãåç»çº¿ãIPå°ååºæ¬ææãåç±»;å°å解æä¸ååæ¹æ³;è½å¤ç¬ç«é ç½®IP并è¿è¡åå解æçåºç¡æä½ççç¸å ³ç¥è¯ã

linuxäºè®¡ç®è¯¾ç¨çåäºå¹å »å¤æ¹ä½åå±çäºè®¡ç®äººæï¼è¯¾ç¨è®¾ç½®ç§å¦åçï¼é¢å0åºç¡äººåï¼æå¦å 容涵çåå广æ³ï¼å¤§å项ç®å®è®ï¼å®ææ§æ´å¼ºã 讲å¸å ¨ç¨é¢æï¼ä¸¥ç®¡å¦ä¹ ï¼å°±ä¸æå¡è´¯ç©¿å§ç»ï¼æ¨èå°±ä¸ã欢è¿åä½å°ä¼ä¼´åæ¥è¯å¬ã

å¦ä½å¨hadoop-2.6.0ä¸ç¼è¯è¿è¡èªå·±ç¼åçjava代ç

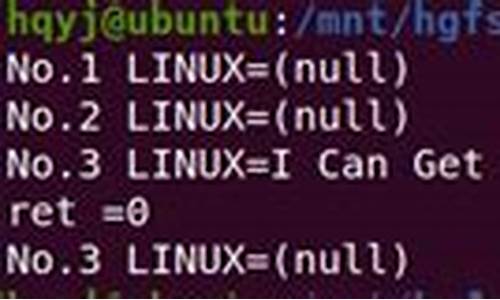

å¨ä¸ä½¿ç¨eclipseæ åµä½¿javaç¨åºå¨hadoop 2.2ä¸è¿è¡çå®æ´è¿ç¨ãæ´ä¸ªè¿ç¨ä¸å ¶å®å为javaç¨åºçç¼è¯ï¼çæjarå ï¼è¿è¡æµè¯ã

è¿ä¸ä¸ªæ¥éª¤è¿ç¨çå½ä»¤é½æ¯è¾ç®åï¼ä¸»è¦çè¿æ¯å¦ä½æ¾å°hadoop 2.2æä¾ç»javaç¨åºç¨æ¥ç¼è¯çjarå ãå ·ä½å¯ä»¥æ¥ç:

HADOOP_HOME/share/hadoop/.wan.demo;

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HADemo {

public static void main(String[] args) {

// TODO Auto-generated method stub

mkdir(args[0]);

}

public static void mkdir(String dir){

Configuration configuration=new Configuration();

FileSystem fs;

try {

fs = FileSystem.get(configuration);

fs.mkdirs(new Path(dir));

fs.close();

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

æHADemo.javaæ件æ·è´å°linuxç¯å¢ä¸

é ç½®HADOOP_HOME/binå°ç¯å¢ä¸ï¼å¯å¨é群ï¼è¿å ¥HADemo.javaæ件ç®å½ä¸

注:ä¸é¢çlibç®å½éé¢çæ件ç±HADOOP_HOME/share/hadoop/mon-2.2.0.jar:lib/hadoop-annotations-2.2.0.jar -d class HADemo.java

2.çæjarå

#jar -cvf hademo.jar -C class/ .

added manifest

adding: com/(in = 0) (out= 0)(stored 0%)

adding: com/wan/(in = 0) (out= 0)(stored 0%)

adding: com/wan/demo/(in = 0) (out= 0)(stored 0%)

adding: com/wan/demo/HADemo.class(in = ) (out= )(deflated %)

3.æµè¯è¿è¡

#hadoop jar hademo.jar com.wan.demo.HADemo /test

æ£æµï¼

#hadoop fs -ls /

ç»æï¼

重点关注

-

clistview源码

2024-12-29 19:06 -

pstream源码

2024-12-29 18:42 -

getenv源码

2024-12-29 17:56